El paciente murió porque la IA alucinó

¿Te imaginas que tu médico te aplique un mal tratamiento porque una IA se inventó parte de tus síntomas? Deja de imaginar. Está pasando.

En el ámbito de la inteligencia artificial generativa, controlar las alucinaciones, la propensión a fabricar datos ficticios, es uno de los retos más importantes a resolver. Eso no está impidiendo, sin embargo, que cientos de empresas de todo el mundo la estén intentando utilizarla para solucionar problemas del mundo real.

Es el caso de Nabla, un producto de transcripción y documentación automática de visitas médicas, utilizado por más de 45.000 doctores en EEUU. Su propuesta de valor es sencilla: ahorra hasta dos horas al día permitiendo a la IA escuchar sus conversaciones médico/paciente.

Nabla ha transcrito más de 7 millones de conversaciones médicas. Para hacerlo se apoya en Whisper, el modelo de reconocimiento de voz de OpenAI. El problema es que un estudio reciente ha demostrado como Whisper alucina hasta el 1% de sus transcripciones.

Nabla, por cierto, por cuestiones de privacidad, borra las grabaciones de las conversaciones, por lo que es imposible comparar lo transcrito con la realidad.

El Efecto Bola de Nieve

El estudio es interesante, pero si no queréis leéroslo, una de sus autoras lo resume brevemente en un hilo de X. Si os interesa el caso, también os recomiendo leer la noticia en APNews.

Por mi parte, quiero aprovechar y tomar un desvío para hablar del efecto bola de nieve y los errores compuestos.

Una tasa de error del 1% puede parecer pequeña, pero supongamos que Whisper alucina y añade un síntoma que no padeces a la transcripción de tu primera visita. Esa transcripción pasa a continuación a uno o varios modelos LLM, que se encargan de procesarla, resumirla y documentarla. Modelos que, a su vez, pueden alucinar, aumentando la posibilidad de error.

En tu siguiente visita, el doctor abrirá su aplicación, leerá sus notas, y partirá de información incorrecta. No sólo eso, sino que la propia herramienta utilizará la transcripción de tu última visita como contexto para esta nueva conversación. Y como los datos de base son erróneos, la posibilidad de que el médico te aplique un mal tratamiento sigue aumentando.

Este efecto de composición se denomina efecto de bola de nieve: un pequeño error inicial en los datos puede crecer hasta convertirse en un problema mucho mayor a medida que se propaga por el sistema.

Conocer este efecto es importante para ser conscientes de las limitaciones de la inteligencia artificial generativa, especialmente en entornos críticos. Si bien este tipo de errores en entornos creativos, como la generación de imágenes o vídeos, pueden ser descartables o hasta beneficiosos, la cosa se complica cuando entramos en terrenos como la salud, el legal o el financiero.

De hecho, la propia política de uso de la API de OpenAI prohíbe su uso en estos entornos:

2. Don’t perform or facilitate the following activities that may significantly impair the safety, wellbeing, or rights of others, including:

a. Providing tailored legal, medical/health, or financial advice without review by a qualified professional and disclosure of the use of AI assistance and its potential limitations

Un humano en el proceso

Mientras la industria de la Inteligencia Artificial Generativa no solucione el problema de las alucinaciones, una buena forma de mitigar el efecto de las mismas consiste en introducir a un humano en el proceso.

No lo digo sólo yo. Microsoft, en sus recomendaciones legales al respecto del uso de sus sistemas de reconocimiento de voz, recomienda precisamente esta estrategia:

Human-in-the-loop: Keep a human-in-the-loop and include human oversight as a consistent pattern area to explore. This means ensuring constant human oversight of the AI-powered product or feature and maintaining the role of humans in decision making. Ensure that you can have real-time human intervention in the solution to prevent harm. This enables you to manage situations when the AI model does not perform as required.

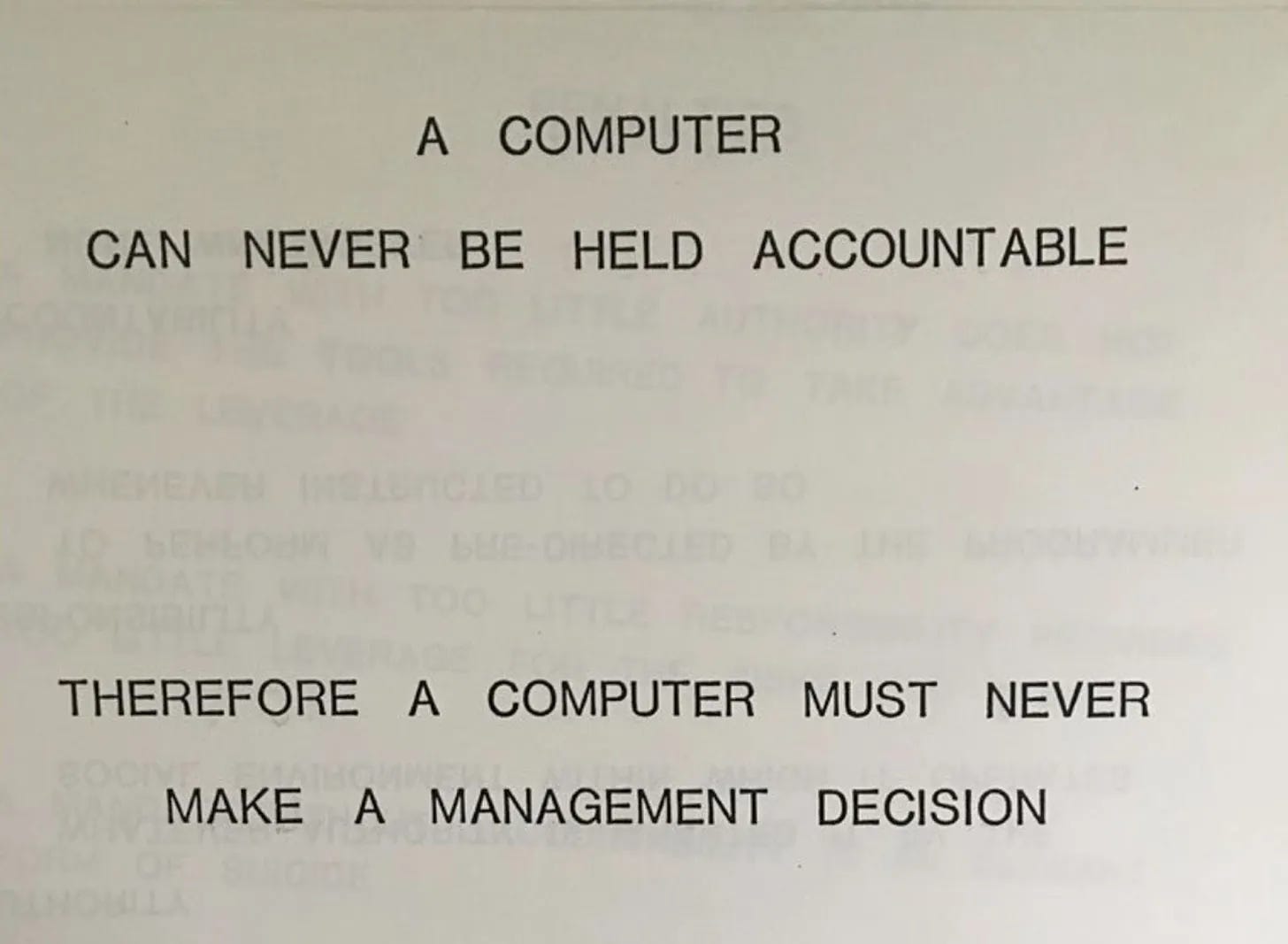

Me gusta citar esta imagen atribuida a una diapositiva de una presentación de IBM a finales de los 70:

El resumen de todo esto es que, a día de hoy, los humanos somos todavía imprescindibles. Los sistemas de Inteligencia Artificial son vitaminas, que pueden aumentar y elevar nuestras capacidades, pero todavía no son lo suficientemente confiables como para poder delegarles tareas críticas.

De hecho, por el efecto bola de nieve, cuantos más agentes IA encadenamos en un sistema, mayor es la probabilidad de error final. Es importante entender este concepto, muchas veces ignorado, a la hora de crear sistemas de este tipo. Probablemente, sea el mayor desafío al que se enfrentan cientos de startups que hoy en día tratan de crear sus soluciones basadas en IA generativa.

Comparto tu artículo, Simón. Me gustó, gracias.

Para ser totalmente justos, deberíamos comparar la tasa de error de un humano o de la cadena de humanos. Ese 1% incluso con su bola se nieve puede llegar a ser más óptimo que los errores humanos acumulados. Además esto abre la puerta a sistemas de QA de limpieza de alucinaciones, disminuyendo el efecto compuesto. Creo que estamos muy cerca de que las máquinas tomen decisiones importantes, con los peligros que entraña.